前不久,中国工程院院士、浪潮集团首席科学家王恩提出了“智算中心”,并表示未来80%的计算都将是AI计算。

近日,IDC公布了《2019年中国AI基础架构市场调查报告》。报告显示,2019年中国AI服务器出货量为79318台,同比增长46.7%。2019年,中国整体通用服务器市场出货量同比下降3.8%,为3,177,540台。

对比通用服务器和AI服务器所提供的计算力总量,就会发现,AI计算已经成为主流的计算形态。伴随着AI计算的高速成长,王恩东院士的论断在几年内将成为现实。

AI计算力已不低于48%

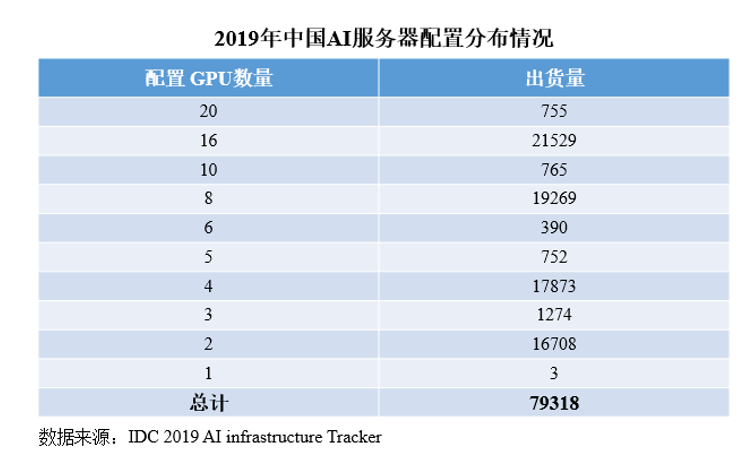

下表是2019年AI服务器的配置分布,经过加权计算可以得出,平均每台服务器配置8.02个GPU加速卡。

为了不低估传统计算力,通用服务器的CPU配置均已浮点性能最高的英特尔至强白金8280可扩展处理器来计算,AI服务器配置以出货量最大的英伟达T4 加速器来计算。至强8280有28核心,每个核心最高主频4GHZ,双精度浮点能力为0.9Tflops, 一台通用服务器(以2颗CPU计算),整体浮点能力为1.8Tflops。英伟达的T4加速器有2560 个 NVIDIACUDA核心,双精度浮点性能为4Tflops,一台AI服务器的浮点计算力超过33.8Tflops,相当37.6台普通服务器。

这一比例同两类服务器的出货量相乘,就可以得到,2019年中国新增计算力中,AI计算力约为48%,这是最保守的估计。

未来的对比,出货量增速、摩尔定律和单机配置

根据IDC预测,中国AI服务器市场在2018-2023年的年复合增长率为37.9%,也就是到2023年,AI服务器市场规模将达到2019年的3.6倍。整体通用服务器市场到2023年,仅能增长34.5%,仅以此估算,到2023年,AI算力占比至少可以提高到72%。

而且,AI计算技术的提升不断加快,CPU技术提升已经遭遇瓶颈。由于制程技术逼近物理极限,CPU正面临摩尔定律失效的挑战,Intel曾公开表示“摩尔定律将不能继续引导电子设备发展的节奏”。GPU等异构计算技术则呈现出超摩尔定律表现,保持着超过高速的性能提升,最新的英伟达安培架构,相比上一代,AI训练性能提高了6倍,AI推理性能提高了7倍。

最后,AI服务器不仅出货量增长速度更高、技术创新更快,而且单机配置也在不断的提高,单台AI服务器可以提供更高的计算力。根据IDC统计数据,2017年平均每台AI服务器配置4.31个GPU,2018年提高为5.1个,到2019年就提高至8.02。

所以,2023年以前,AI计算力的占比就可以超过80%。

AI计算改变了什么

AI正在渗透我们的日常生产、生活中,AI计算的发展为“一切AI化”提供了基本的技术基础。同时,伴随着AI计算的发展,数据中心将逐渐演变为智算中心,并成为水厂、电站一样的社会必要基础设施。

智算中心并不仅是输出AI计算,不仅是应用AI技术、“以智生智”,而是基于全新技术的计算力生产中心。Google等企业已经在数据中心中广泛采用AI技术,这些数据中心距离真正意义的智算中心仍有距离。液冷、融合架构、开放计算、模块化数据中心等下一代数据中心技术正在形成和发展中,AI计算将撬动新一代ICT技术和产业的发展壮大。例如,AI计算将推动将直接推动液冷的发展和应用,而液冷技术带来的巨大的散热能力冗余,可以为技术创新提供巨大的想象空间,比如直接将多个处理器直接集成在一片硅晶圆上,不再切割。伴随着新一代技术的成熟,智算中心也将迎来自己的时代。(一鸣)

关键词: IDC

营业执照公示信息

营业执照公示信息